Sedan lanseringen av Ray-Ban-glasögonen 2023 har Meta fortsatt att förbättra sina möjligheter med regelbundna funktionsuppdateringar. Den senaste firmware, version 11, introducerar uppgraderade AI-funktioner, inklusive live AI-driven multimodal funktionalitet, realtidsöversättning och Shazam-integration.

Prata med Meta AI naturligt

Den här senaste utgåvan ökar avsevärt Ray-Bans smarta glasögon (recension) multimodala möjligheter genom att lägga till stöd för livevideoflöde.

Med live AI aktiverad kan Ray-Ban Meta smarta glasögon kontinuerligt fånga den omgivande miljön och svara på frågor utan att behöva ett väckningskommando eller manuell aktivering. Markerade funktioner inkluderar att känna igen ingredienser för att föreslå recept och tillhandahålla kontextuell information om objekt och scener i sikte.

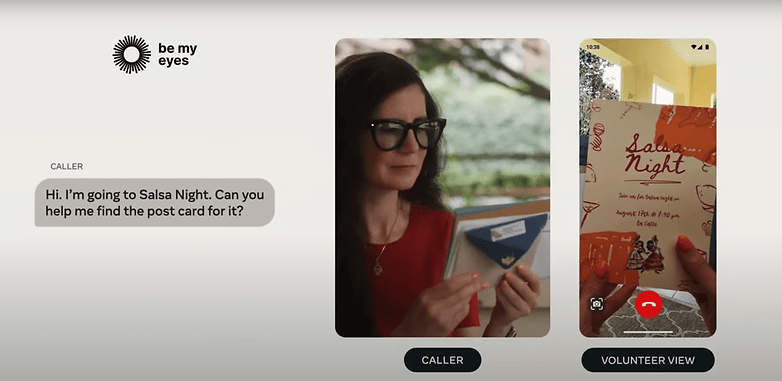

Dessutom fungerar den här funktionen sömlöst medan du är på ett samtal och ansluten till Ray-Ban-glasögonen, vilket demonstrerades av Meta i september.

Meta demonstrerade Live AI på Ray-Ban smarta glasögon i september. / © Meta

Liveöversättning kommer till Ray-Ban Meta Smart Glasses

Assistenten stöder också naturliga avbrott, vilket gör det möjligt för användare att byta ämne eller bygga på tidigare frågor sömlöst. Detta bygger på Metas tidigare ”Se och fråga”-funktion, som krävde att assistenten tillkallades för varje fråga – en begränsning som nu är eliminerad.

Kommer du ihåg Googles prototyp av smarta glasögon från två år sedan som lovade översättning i realtid? Meta tar nu med sig en liknande funktion till sina smarta glasögon.

- Missa inte: Ray-Ban Meta Smart Glasses Headliner praktiskt

Ray-Ban Meta smarta glasögon kan automatiskt översätta talade språk till engelska, spela upp översättningen genom enhetens högtalare eller visa den i Meta-appen. Språk som stöds vid lanseringen inkluderar franska, italienska och spanska.

Fråga Metas Ray-Ban-glasögon vilken låt som spelas

Meta har också integrerat Shazam för sångigenkänning. Men till skillnad från live AI och översättning kräver denna funktion manuell väckning av Meta AI. Användare kan sedan be assistenten att identifiera sånger eller psalmer som spelas i bakgrunden.

Uppdateringen tillsammans med funktionerna är för närvarande tillgänglig via en väntelista och kommer först att rullas ut i USA och Kanada innan den expanderar till fler länder. Meta sa dock inte när vi kan se dessa tillägg utökas globalt.

Bättre AI-funktioner, men fler sekretessproblem?

Även om dessa AI-drivna funktioner utan tvekan är imponerande, väcker de pågående oro för integritet och datainsamling – frågor som har omgett bärbara enheter som Ray-Ban smarta glasögon de senaste åren.

Enligt Meta bearbetas bilder, text och annan data som fångas av enheten i molnet och används för att träna dess AI-modeller. Detta är något användare bör tänka på innan de aktiverar dessa nya funktioner.

Vad är dina tankar om de nya AI-verktygen i Metas Ray-Ban Smart Glasses? Låt oss höra din åsikt i kommentarerna.

Källa:

Meta