iPhone 14 Pro har fyra kameror, där Apple skrev specificerat på produktsidan som huvudkamera, ultravidvinkel och dubbel- och trippelzoom. Däremot syns bara tre kameror på baksidan. Lösningen på detta till synes gåta? A ”virtuell kamera” med dubbel zoom, möjliggjort av 48 MP fyrpixelsensor. Är det här fräck marknadsföring eller faktiskt användbar information?

Anten fortsätter att stiga 2022 när det gäller det galna megapixelloppet. Efter att den första 108 MP-smarttelefonen kom ut på marknaden i slutet av 2019, korsades 200 MP-märket denna månad med Motorola Edge 30 Ultra (recension) och Xiaomi 12T Pro (praktiskt).

Även den tidigare nämnda iPhone 14 Pro har hoppat till en 48 MP-kamera i år, vilket är mycket ovanligt för Apple. Det spännande med extremt högupplösta sensorer är dock inte de 100 MB bilder som används för utskrifter i huset, utan för deras zoom.

iPhone 14 Pro (Max) har en kamera med 48 MP upplösning för allra första gången. Är det någon mening? / © NextPit

Hur fungerar 2x zoomen i iPhone 14 Pro?

Till skillnad från fullskaliga digitalkameror har de allra flesta smartphones inga zoomobjektiv som kan ändra brännvidden genom att flytta linserna, på grund av utrymmesbegränsningar. Istället finns det separata sensorer för olika zoomnivåer. iPhone 14 Pro har en sensor för ultravidvinkel (0,5x), en för vidvinkel (1x) och en för telefoto (3x).

När du zoomar med tvåfingergesten i kameraappen zoomar smartphonen nu digitalt in i bilden av en kamera tills förstoringen av nästa kameramodul uppnås innan den gör bytet. När den digitala förstoringen ökar kommer kvaliteten naturligtvis att minska. Graden av minskning beror på kameran i fråga.

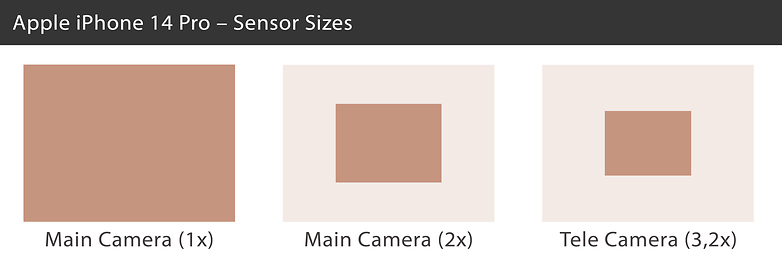

Se en jämförelse av de effektiva sensorstorlekarna i iPhone 14 Pro. / © NextPit

IPhone 14 Pros huvudkamera är en 1/1,28-tums bildsensor som mäter 9,8 gånger 7,3 millimeter, med en upplösning på 48 MP. Med 2x zoomen skär Apple helt enkelt ut en 12-megapixel sektion från sensorns mitt, som då fortfarande mäter 4,9 gånger 3,7 millimeter på sensorn – och motsvarar alltså ungefär 1/3-tumsformatet. Det räcker ändå för anständiga bilder under bra ljusförhållanden.

Vid 3x zoom växlar Apple sedan till nästa 12-megapixelsensor (som faktiskt är mer som 3,2x med en motsvarande brännvidd på 77 millimeter). Med 1/3,5-tumsformatet eller 4,0 gånger 3,0 millimeter är sensorn återigen lite mindre än ”2x sensor” som klipptes ut från mitten av huvudkameran.

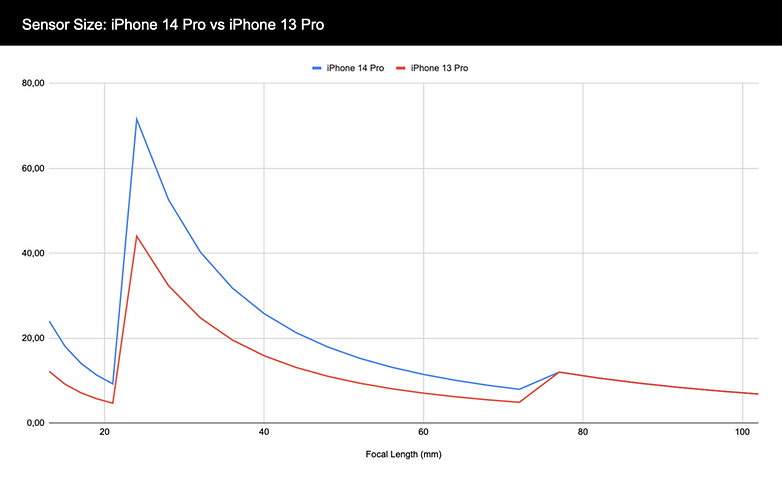

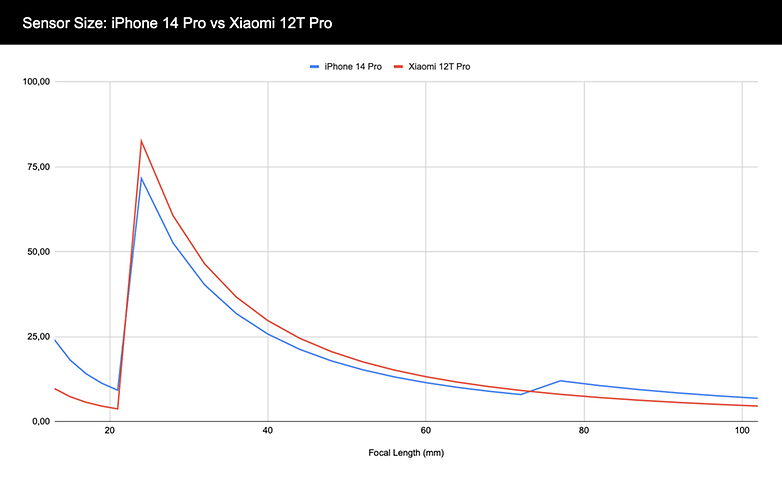

I följande diagram kan du se hur mycket sensorarea som är tillgänglig för kameran i iPhone 14 Pro och iPhone 13 Pro vid olika brännvidder. Ultravidvinkeln (13 millimeter) börjar längst till vänster på kanten. Huvudkameran (24 millimeter) visar en betydande ökning. Upp till telekameran (77 millimeter) har iPhone 14 Pro alltid mer tillgänglig sensoryta än iPhone 13 Pro. Slutligen förblir telekameran identisk.

Här kan du se hur mycket sensoryta som är tillgänglig för kameran i iPhone 14 Pro och iPhone 13 Pro vid motsvarande brännvidd. / © NextPit

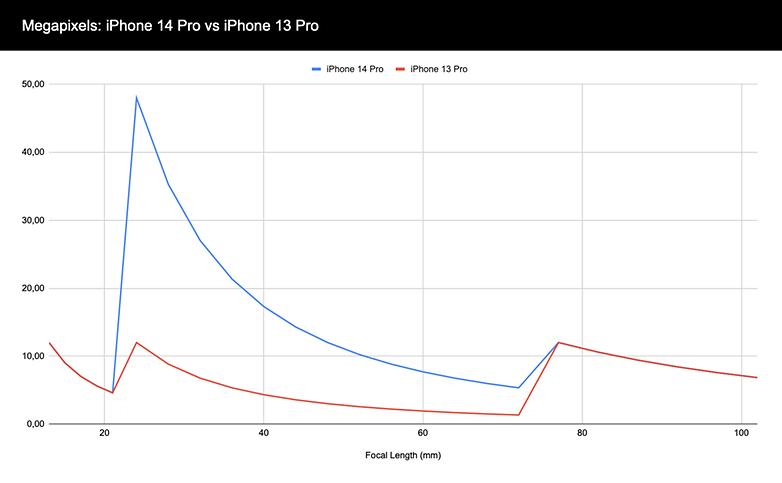

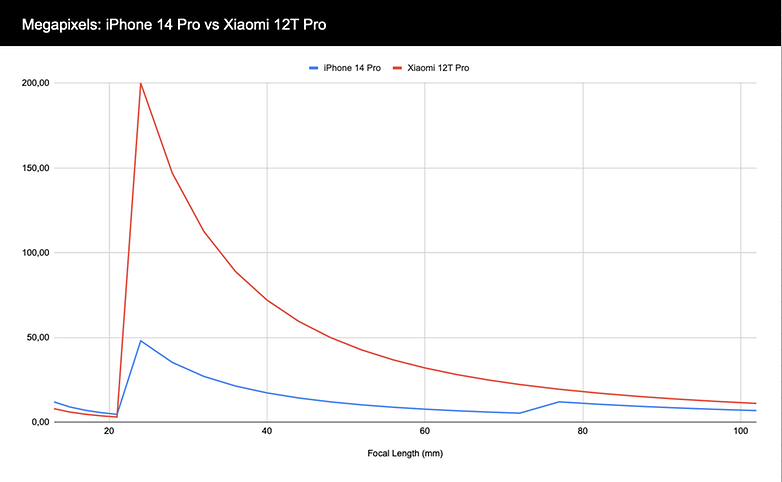

Diagrammet ovan är också intressant, bara med megapixlar (MP) istället för sensorområdet sett på den vertikala axeln. Även om utvecklingen är identisk för de ultravida och telefotosensorerna som är 12 MP vardera, märks hoppet till 48 MP tydligt. iPhone 14 Pro har betydligt mer upplösning att leka med i digital zoom mellan 1x och 3,2x.

iPhone 14 Pro har också betydligt mer rörelseutrymme när det gäller upplösning. / © NextPit

Hur stor och högupplöst måste den vara?

Den hittills diskuterade iPhone 14 Pro är inte ens smartphonen med den högsta upplösningen eller den största sensorn. Den här veckan lanserade Xiaomi 12T Pro, som erbjuder en 200 MP-sensor – och helt avstår från en telekamera i gengäld. Men hur mycket mer utrymme för digital zoom erbjuder så många megapixlar? Låt oss ta en titt på det i jämförelse med iPhone 14 Pro:

iPhone 14 Pro har också mycket mer rörelseutrymme när det gäller upplösning. / © NextPit

Den viktigaste faktorn förutom upplösningen är dock sensorområdet som är tillgängligt för kameran vid olika brännvidder. Isocell HP1 installerad i Xiaomi 12T Pro är avsevärt större än huvudkameran i iPhone 14 Pro med 1/1,22 tum, men den förlorar sedan när det gäller det tillgängliga sensorområdet när Apple-smarttelefonen växlar till telezoom:

Xiaomi 12T Pro har mer sensorområde tillgängligt med huvudkameran. iPhone 14 Pro vinner dock när man byter till telesensorn. / © NextPit

Och hur är det med quad-bayer?

Vi har ignorerat en faktor hittills: färgmaskerna ovanför sensorn. För att förklara Quad-Bayer måste vi först titta på hur bildsensorer fungerar. En bildsensor består av massor av små ljussensorer som bara mäter mängden infallande ljus utan att kunna urskilja färger. 12 MP innebär att man har 12 miljoner sådana ljussensorer.

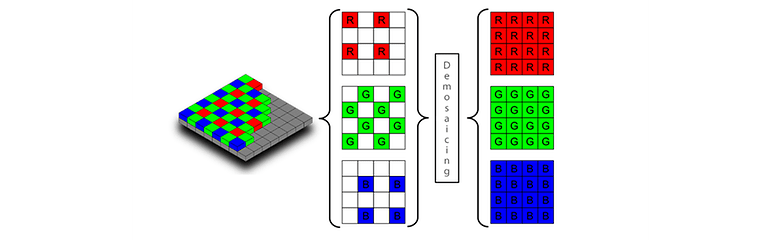

För att förvandla denna svartvita sensor till en färgsensor placeras en färgmask över sensorn för att filtrera det infallande ljuset efter grönt, rött eller blått. Bayer-masken som används i de flesta bildsensorer delar alltid två gånger två pixlar i två gröna pixlar och en röd och en blå pixel. En sensor med en upplösning på 12 MP har därför sex miljoner gröna pixlar och tre miljoner blå och röda pixlar vardera.

En Bayer-sensor (vänster) har dubbelt så många gröna pixlar som röda och blå pixlar. Under demosaicing fylls de resulterande luckorna och RGB-pixlar interpoleras. / © Sony

I demosaicing, eller de-bayering, använder bildbehandlingsalgoritmerna ljusstyrkan för de omgivande pixlarna av en annan färg för att sluta sig till RGB-värdet för varje pixel. En mycket ljusgrön pixel omgiven av ”mörk” blå och röda pixlar blir därmed helt gröna. Och en grön pixel bredvid de helt exponerade blå och röda pixlarna blir vit. Och så vidare, tills vi har en bild med 12 miljoner RGB-pixlar.

Med högre upplösningssensorer ser färgmasken dock annorlunda ut. Med den så kallade quad-bayer-sensorn, vanligtvis i 50 MP-området, finns det fyra ljusstyrkapixlar under varje röd, grön eller blå pixel. 108 MP-sensorerna grupperar till och med nio (3×3) pixlar under ett färgområde, och 200 MP-sensorerna har 16 (4×4) pixlar. Sony kallar detta quad-bayer, medan Samsung använder tetra-, nona- eller tetra2pixel.

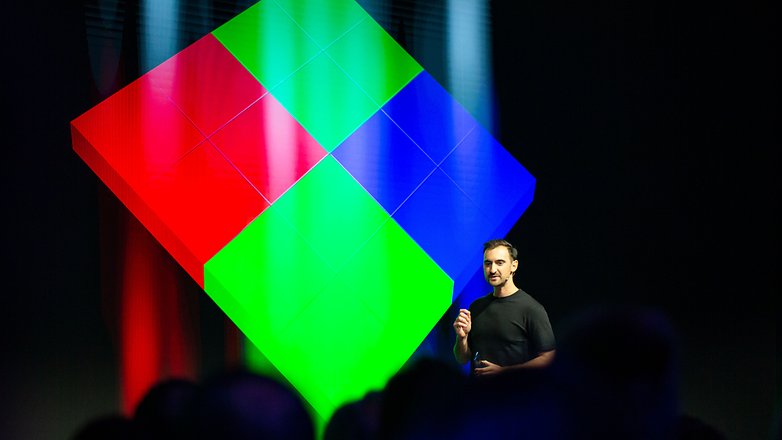

Den första sensorn med en quad-bayer-mask var Sony IMX586, som visas här vid presentationen av OnePlus 7. / © NextPit

Medan bildsensorerna faktiskt har en upplösning på upp till 200 MP när det gäller ljusstyrka, stannar färgmasken vid 12 MP. Detta är inte heller ett problem, eftersom ljusstyrkans upplösning är viktigare än färgupplösningen. Ändå, vid extremt höga digitala zoomar, minskar färgupplösningen så småningom så mycket att bildfel uppstår.

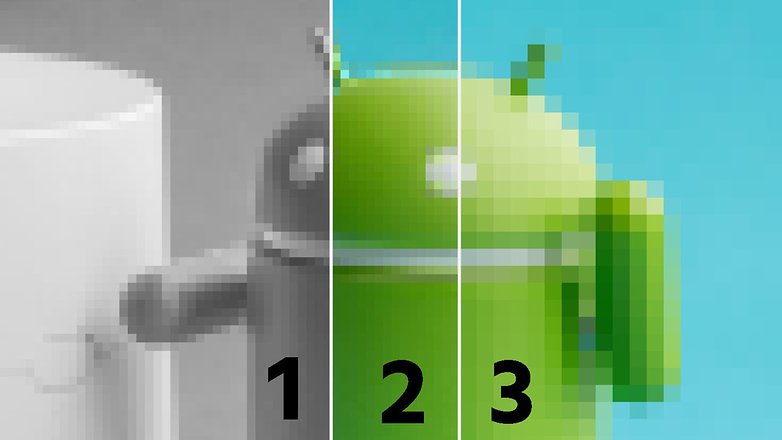

Som ett exempel har vi bearbetat ett foto av en liten android här. Till vänster (1) ser du en gråskalebild, till höger (3) en RGB-bild med kvartad upplösning. Mittbilden är en sammansättning av både vänster- och högerbilder – och vid första anblicken ser resultatet mycket bra ut. Vid närmare eftertanke är dock övergången mellan grönt och blått i toppen av androiden oren.

Och det är precis vid sådana övergångar som artefakter uppstår när man zoomar för långt in i en sensor där färgmasken har lägre upplösning än själva sensorn. Förresten, Samsung använde förmodligen en 64 MP-sensor med en RGB-matris som är otypisk för den här upplösningen för sin mycket utskällda 1,1x telefotosensor i S20 Plus och S21 Plus av exakt denna anledning.

Ljusstyrkans upplösning är viktigare än färgupplösningen: Denna centrerade bild (2) skapades från den högupplösta svartvita bilden (1) och den lågupplösta färgbilden (3). / © NextPit

Summan av kardemumman är att det är svårt att rent av hårdvaruspecifikationerna avgöra hur bildkvaliteten beter sig i kameror, särskilt eftersom en mycket avgörande roll i slutändan också går till tillverkarens algoritmer. Och den så kallade re-mosaicingen är också en stor utmaning för sensorer med 2×2, 3×3 eller 4×4 bayermasker. Till skillnad från normal avmosaik måste färgvärdena interpoleras över allt större sensorområden och med allt större komplexitet.

Å andra sidan ger de allt större sensorerna också egna problem. För att hålla linserna kompakta måste tillverkarna använda linser som bryter ljuset mer och mer och därmed stöter på problem med kromatiska aberrationer och andra artefakter, speciellt i kanten av bilden. Och det korta skärpedjupet är också ett problem på nära håll.

Därför är det fortfarande spännande, och jag hoppas att du tyckte att denna resa in i världen av extremt stora och extremt högupplösta bildsensorer var intressant. Hur ser din drömkamera ut i en smartphone? Jag ser fram emot dina kommentarer!