Har du någonsin undrat om du kunde köra något som chatgpt lokalt på din Mac utan att behöva internet? Med bara lite installation kan du faktiskt. Det också gratis. Oavsett om du vill hålla dina chattar privata eller bara vill ha offline åtkomst till AI, så här kan du köra kraftfulla stora språkmodeller lokalt på din Mac.

Vad behöver du för att köra en LLM lokalt på en Mac?

Innan vi dyker in och kolla in installationen, här är vad du behöver:

- En MAC med äppelkisel (M1, M2 eller M3 rekommenderas)

- Minst 8 GB RAM (16 GB eller mer är bättre)

- Cirka 4–10 GB gratis diskutrymme (beroende på modell)

- En fungerande internetanslutning (endast för installation)

- Grundläggande kännedom om att använda MacOS Terminal -appen (du behöver inte vara proffs)

Hur man kör en LLM lokalt på en Mac

Vi kommer att använda ett gratis verktyg som heter Ollama, som låter dig ladda ner och köra LLMS lokalt med bara några kommandon. Så här kommer du igång:

Steg 1: Installera homebrew (hoppa över om det redan är installerat)

Homebrew är en pakethanterare för macOS som hjälper dig att installera appar från Terminal -appen. Om du redan har Homebrew installerat på din Mac kan du hoppa över detta steg. Men om du inte gör det, så här kan du installera det:

- Öppna Terminal -appen från LaunchPad eller Spotlight.

- Kopiera och klistra in följande kommando och slå tillbaka:

/bin/bash -c "$(curl -fsSL https://raw.githubusercontent.com/Homebrew/install/HEAD/install.sh)"- Vänta tills installationen är klar. Det kan ta några minuter. När du är klar, kontrollera om det fungerar genom att skriva:

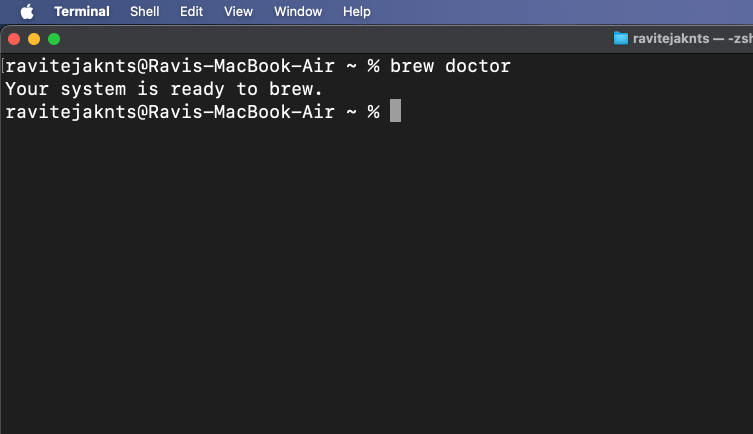

brew doctor

Om du ser ”Ditt system är redo att brygga” är du bra att gå.

Om du har några problem eller vill ha en mer detaljerad steg-för-steg-process, kolla in vår guide för hur du installerar homebrew på en Mac.

Steg 2: Installera och kör Ollama

Nu när Homebrew är installerad och redo att använda på din Mac, låt oss installera Ollama:

- Kör i ett terminalfönster: Kör:

brew install ollama- Efter installationen startar Ollama -tjänsten genom att köra:

ollama serve

Lämna detta fönster öppet eller minimera det. Detta kommando håller Ollama igång i bakgrunden.

Alternativt, ladda ner Ollama -app och installera den som alla vanliga Mac -appar. När du är klar öppnar du appen och håll den igång i bakgrunden.

Steg 3: Ladda ner och kör en modell

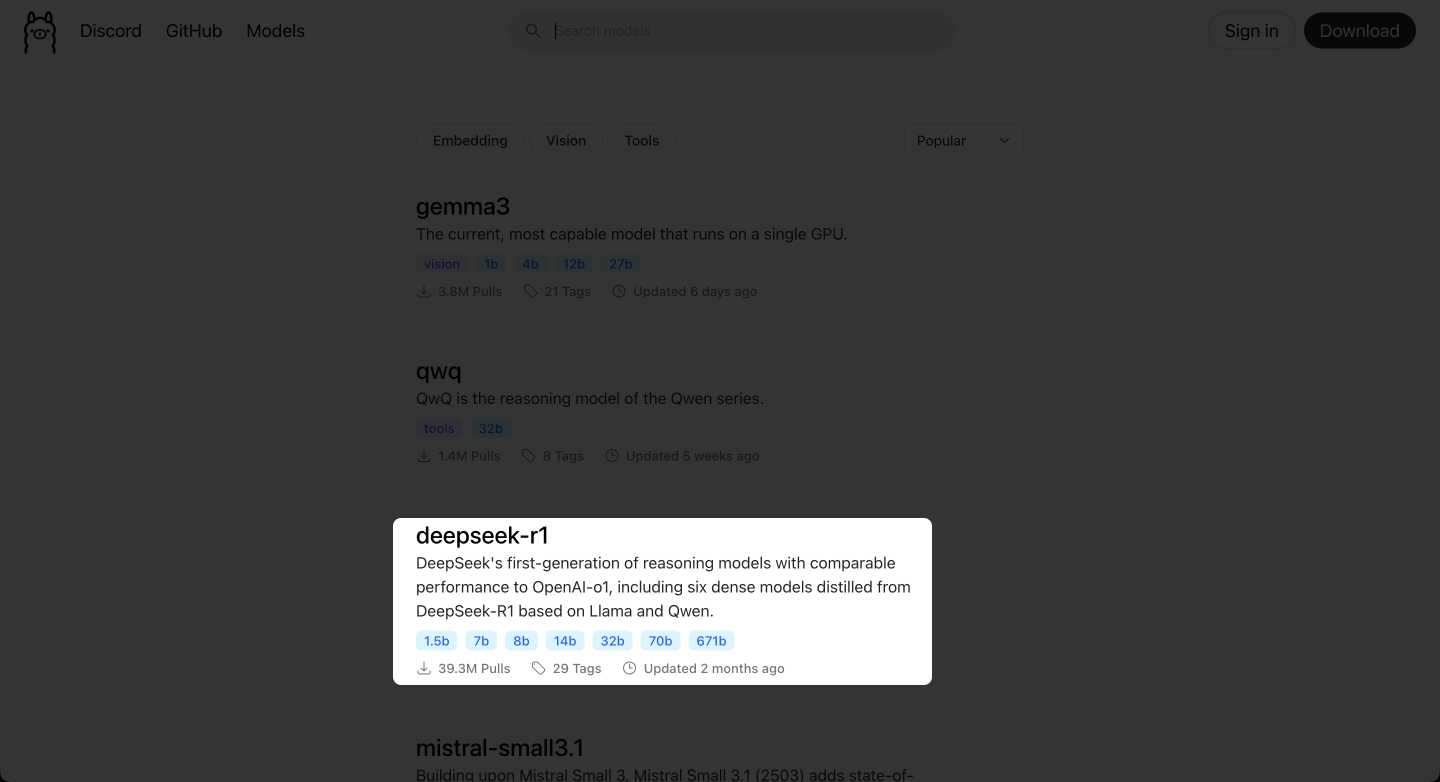

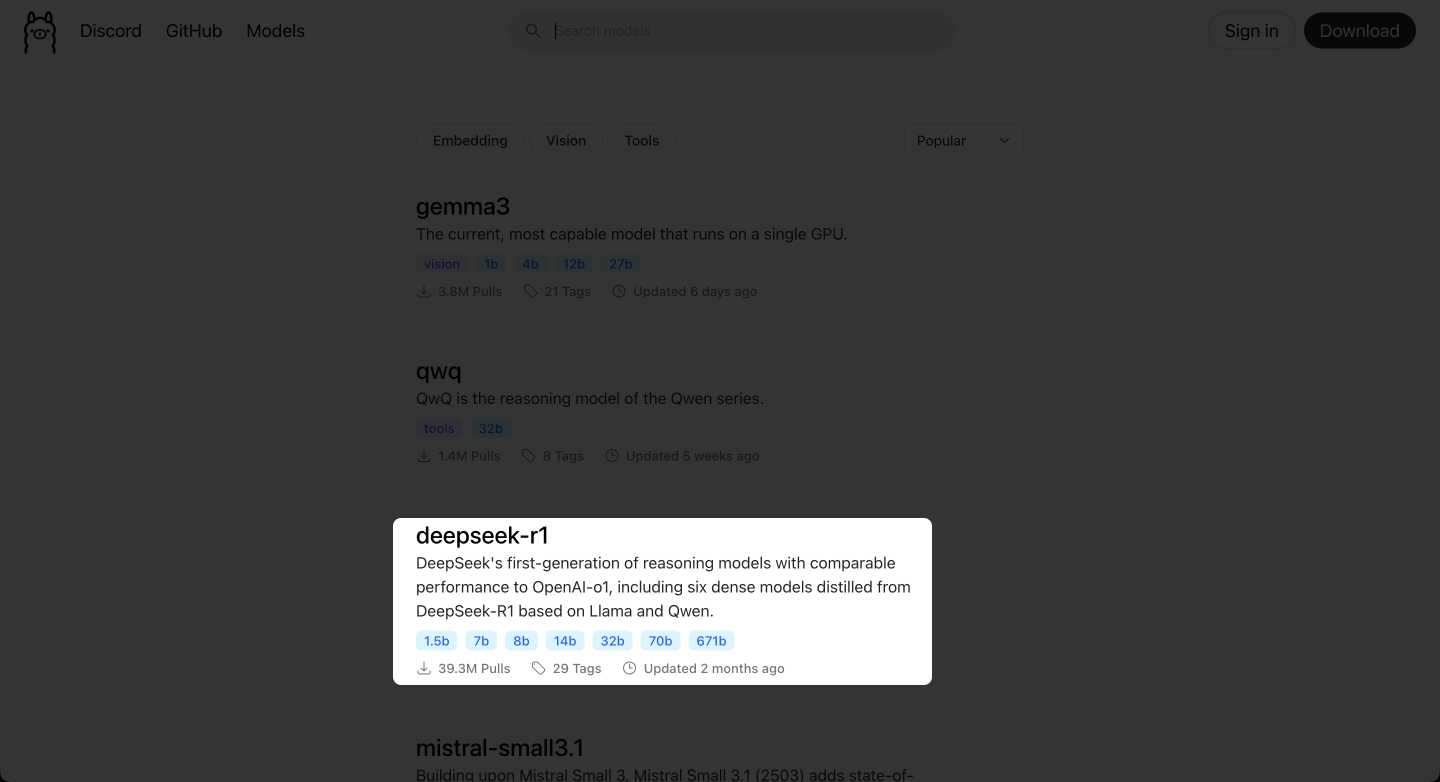

Ollama ger dig tillgång till populära LLM: er som Deepseek, Metas Llama, Mistral, Gemma och mer. Så här kan du välja och köra en:

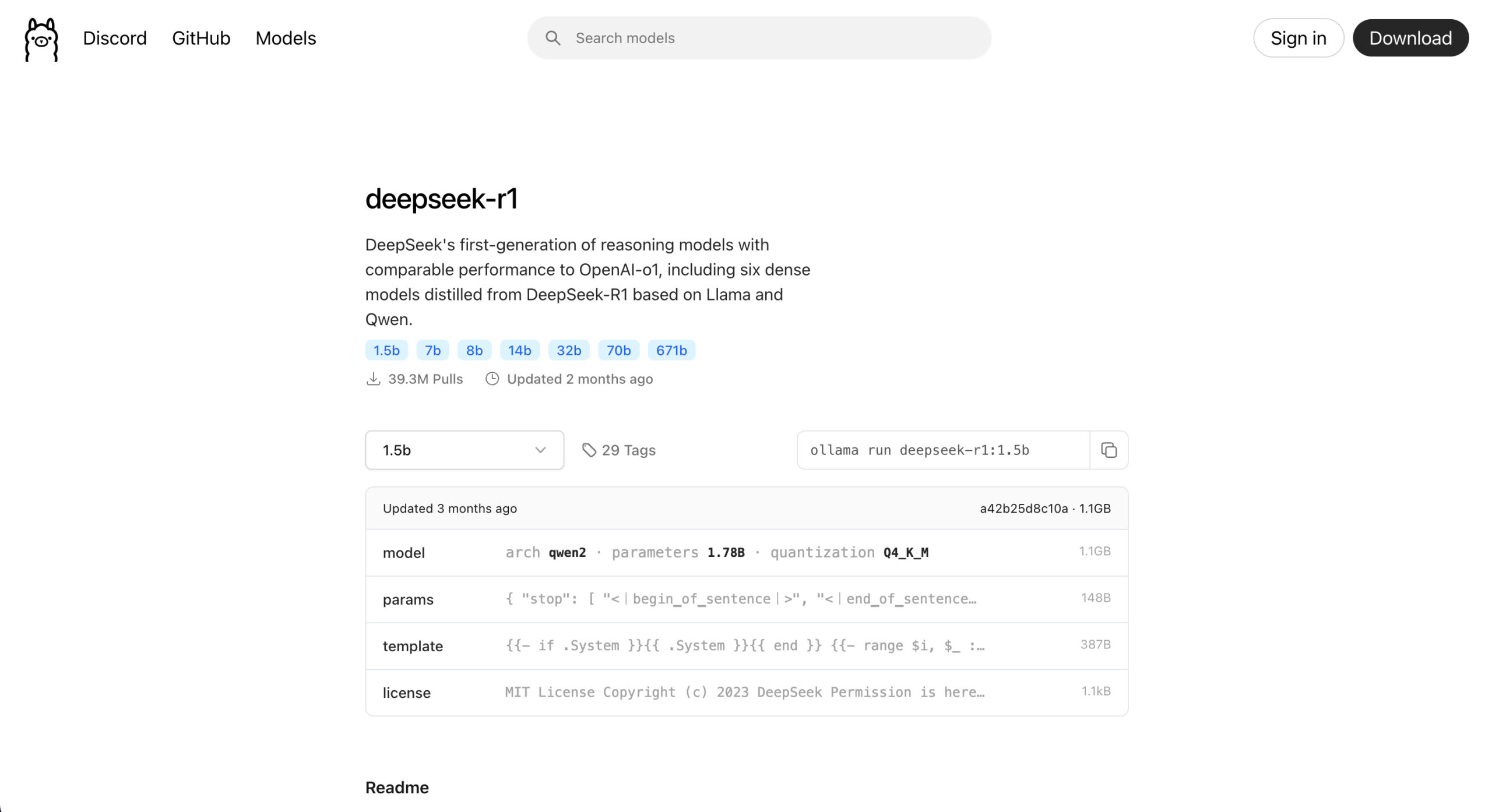

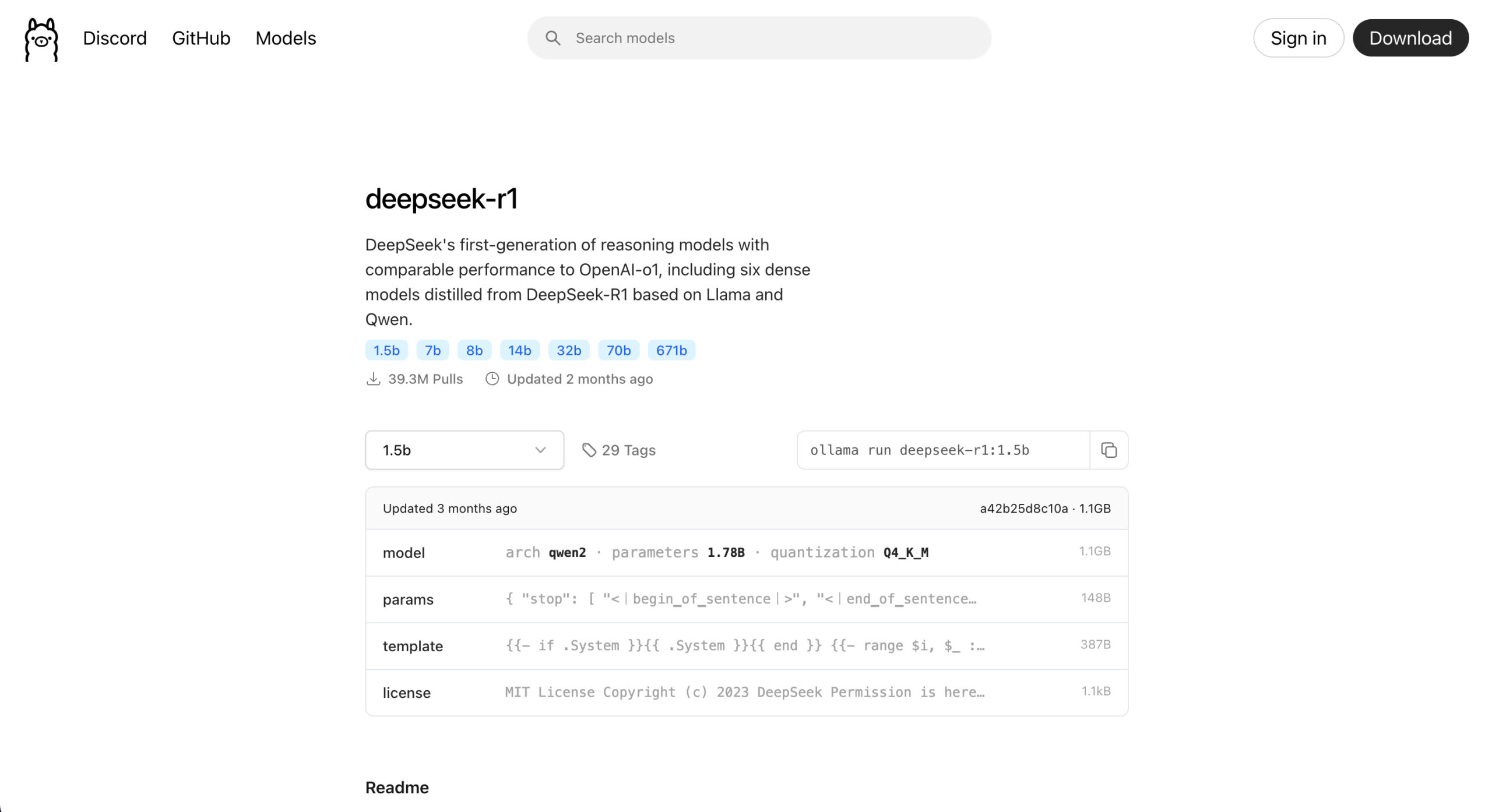

- Besöka Ollama söksida För att hitta alla AI -modeller kan du köra lokalt via Ollama på din Mac.

- Välj den LLM -modell du vill installera. (Jag använder Deepseek-R1 eftersom det är en liten modell som bara tar 1,1 GB utrymme och är effektiv.)

- På den sidan hittar du ett kommando som detta:

ollama run [model-name]. Det är annorlunda för olika modeller.

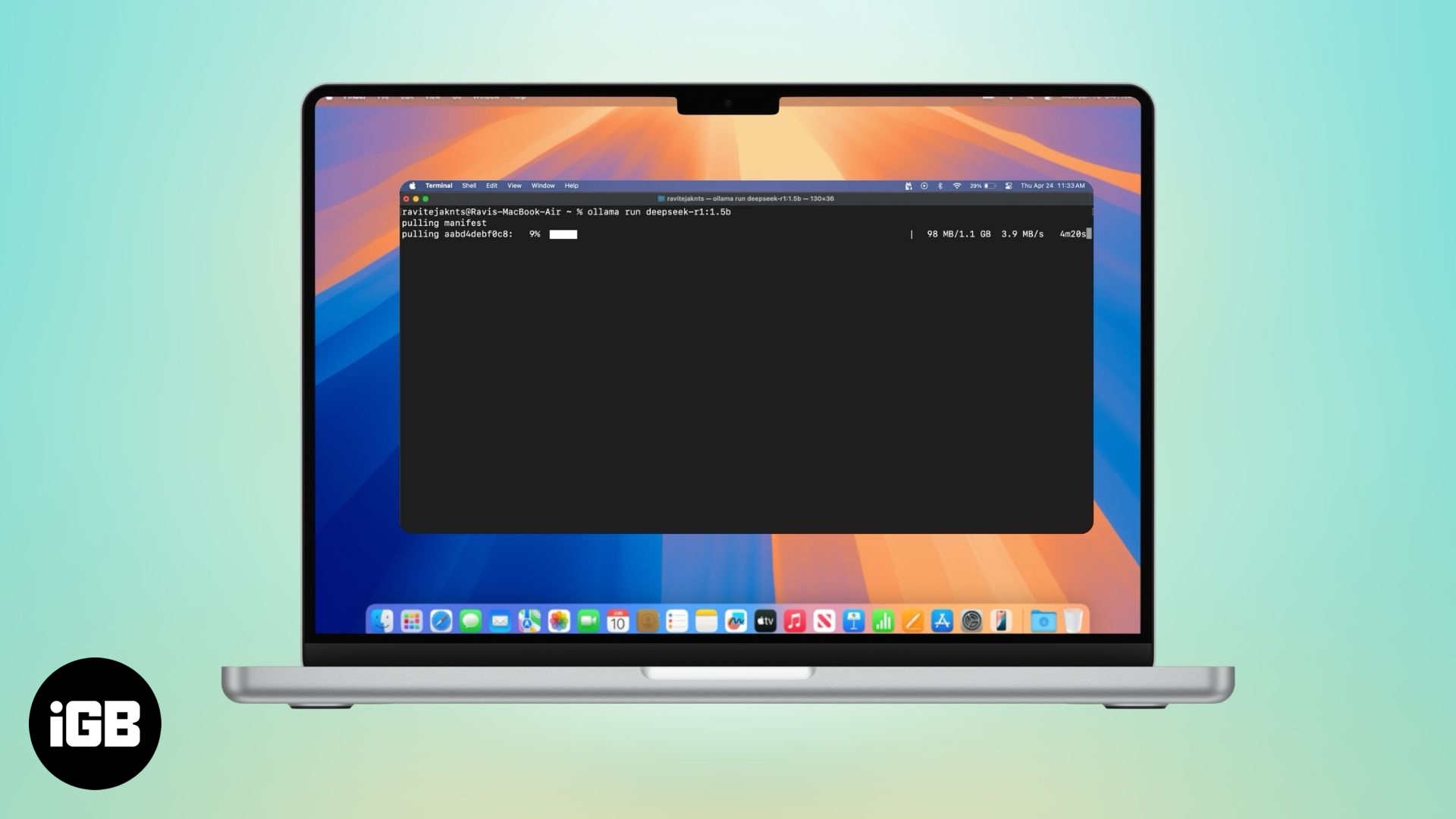

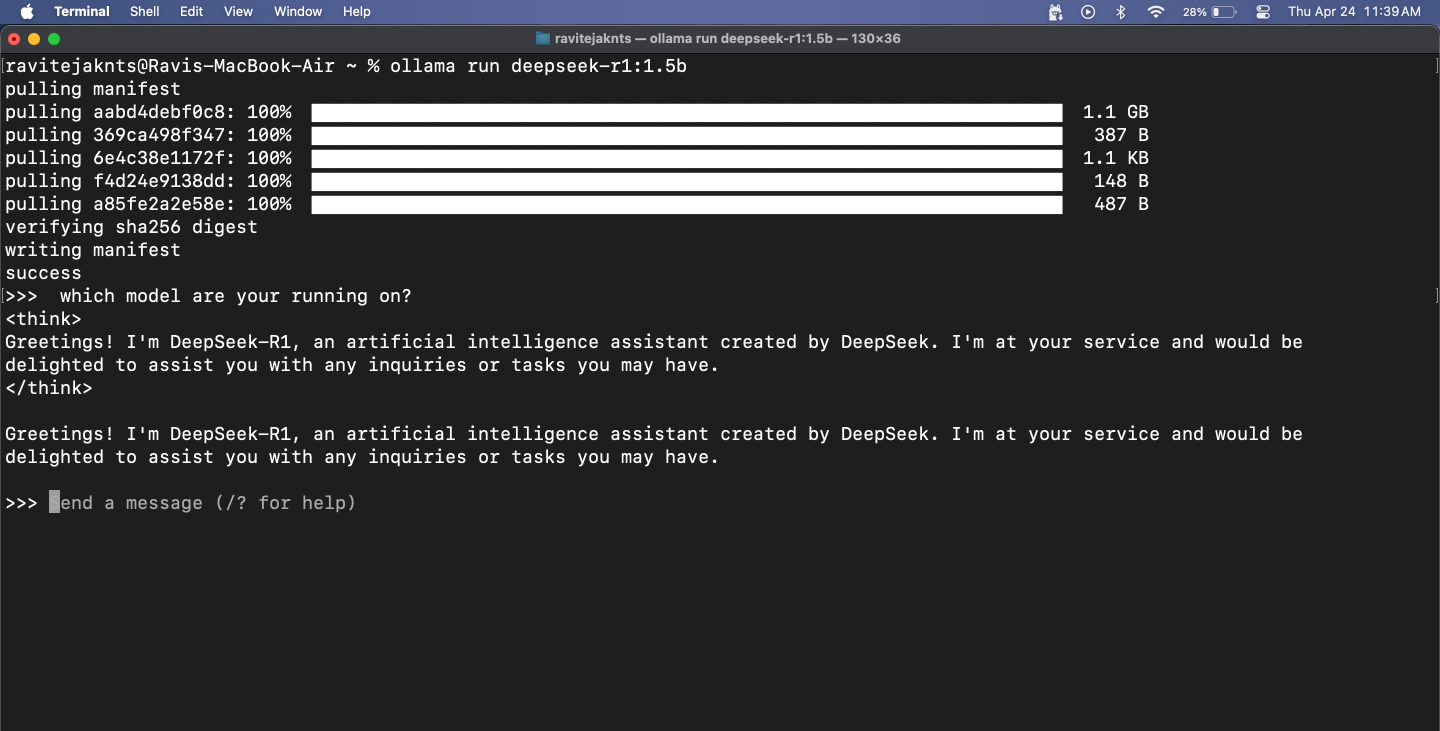

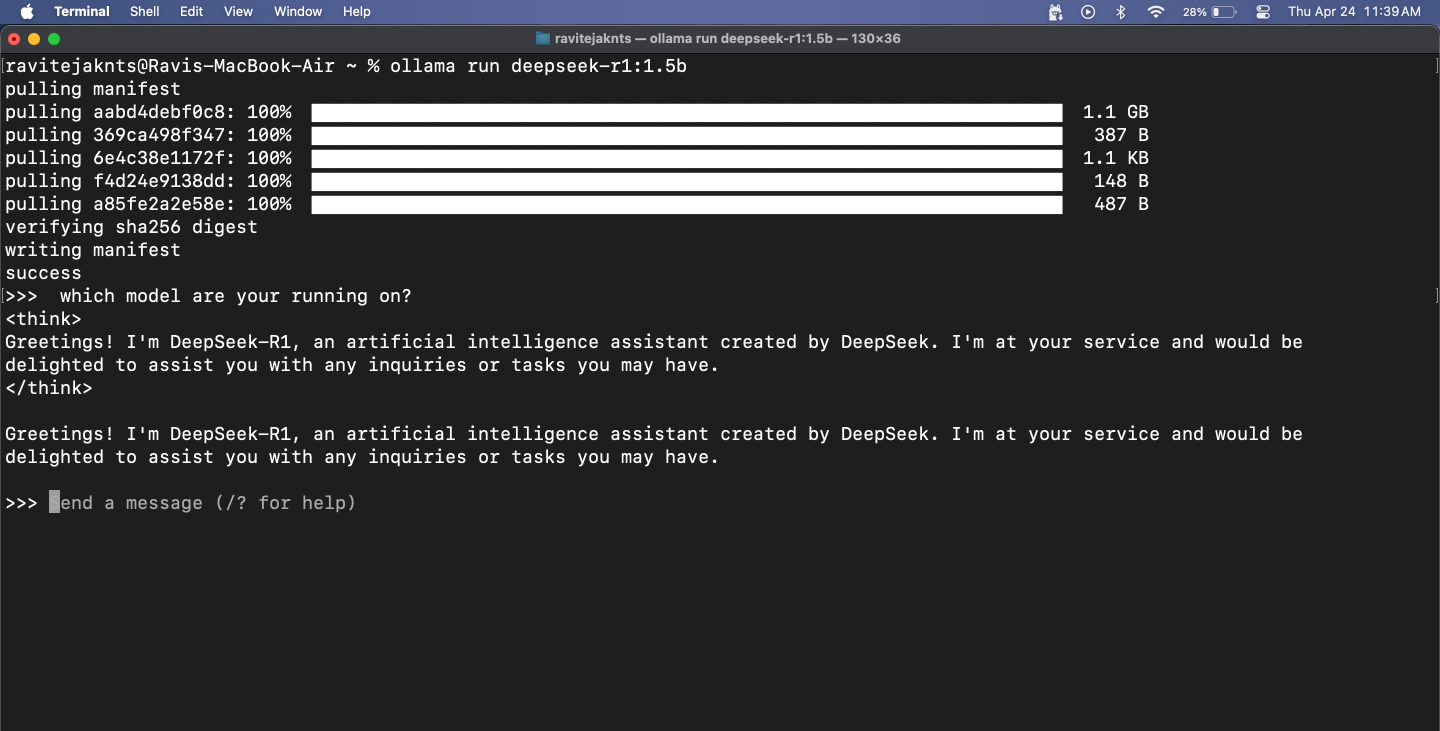

- För Deepseek R1 1,5B -modell:

ollama run deepseek-r1:1.5b - För Llama 3 -modell:

ollama run llama3 - För mistral:

ollama run mistral

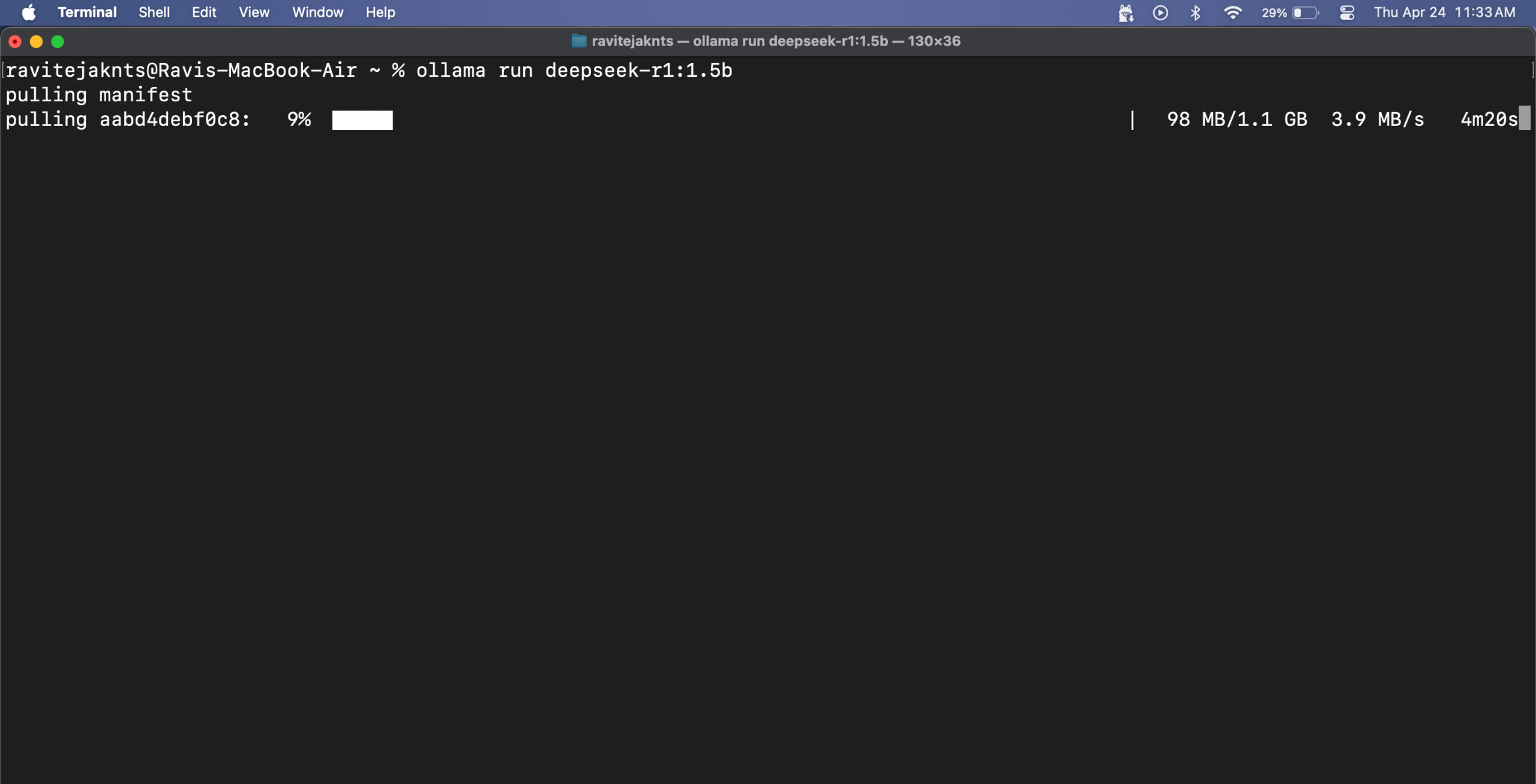

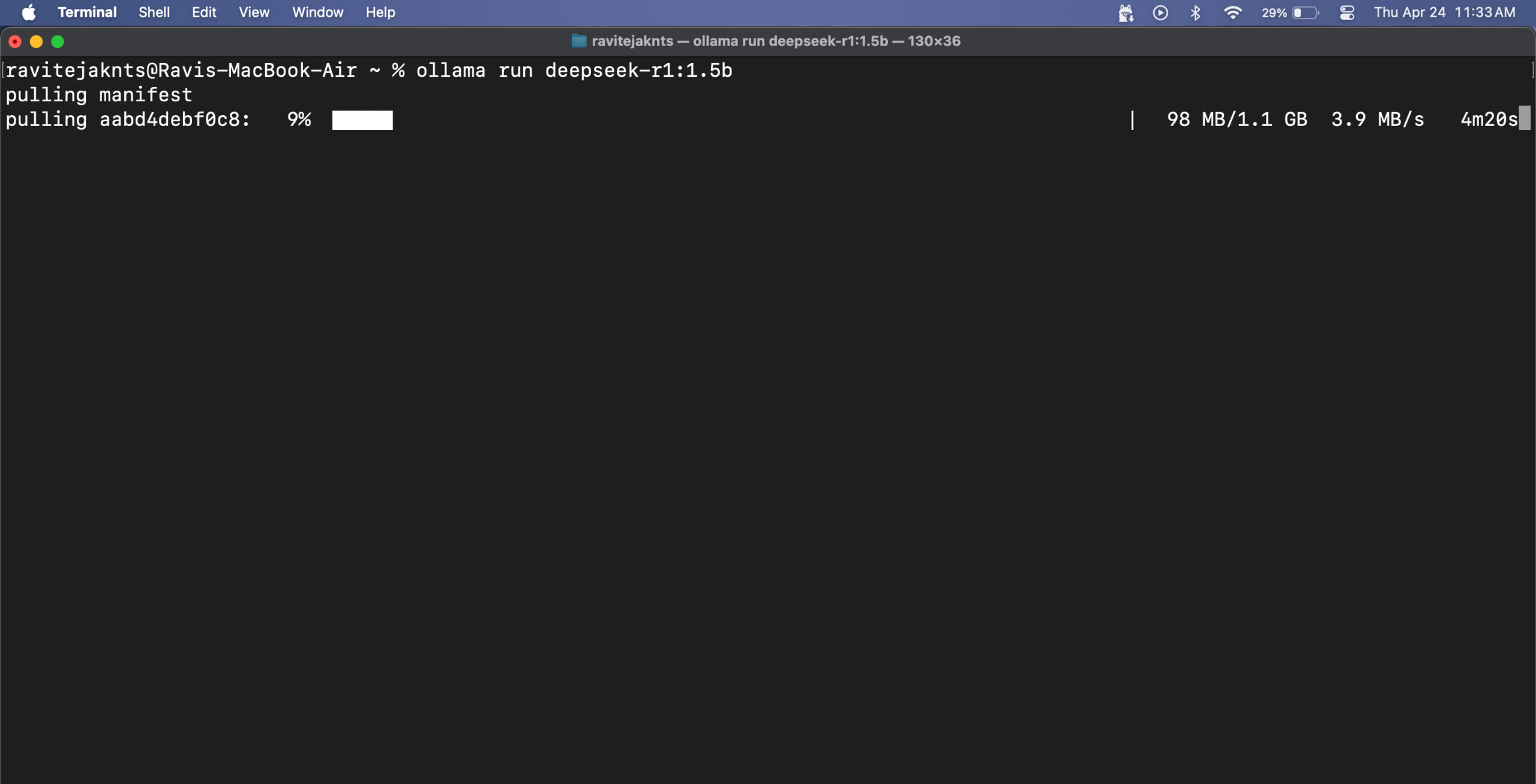

- Kopiera och klistra in det kommandot i terminalfönstret. Första gången du kör detta kommer Ollama att ladda ner modellen. Det kan ta några minuter beroende på din internethastighet.

- När modellen har laddats ner ser du en prompt för att skriva in din inmatning. Du chattar nu med modellen!

Om du väljer en stor modell, förvänta dig lite fördröjning – efter alla körs hela modellen lokalt på din MacBook. Mindre modeller svarar snabbare, men de kan kämpa med noggrannhet, särskilt för matematik och logikrelaterade uppgifter. Kom också ihåg att eftersom dessa modeller inte har någon internetåtkomst kan de inte hämta information i realtid.

Som sagt, för saker som att kontrollera grammatik, skriva e -post eller brainstorma idéer fungerar de briljant. Jag har använt Deepseek-R1 i stor utsträckning på min MacBook med en webbgränssnitt, som också låter mig ladda upp bilder och klistra in kodavsnitt. Medan dess svar-och särskilt dess kodfärdigheter-inte var lika skarpa som toppmodeller som Chatgpt eller Deepseek 671B, får det fortfarande de flesta vardagliga uppgifter utan att behöva internet.

Steg 4: Chatta med modellen i terminal

När modellen är igång kan du helt enkelt skriva ditt meddelande och slå tillbaka. Modellen kommer att svara direkt nedan.

För att lämna sessionen trycker du på kontrollen+D på tangentbordet. När du vill börja chatta igen, använd bara samma ollama run [model-name] kommando. Eftersom modellen redan laddas ner kommer den att lanseras direkt.

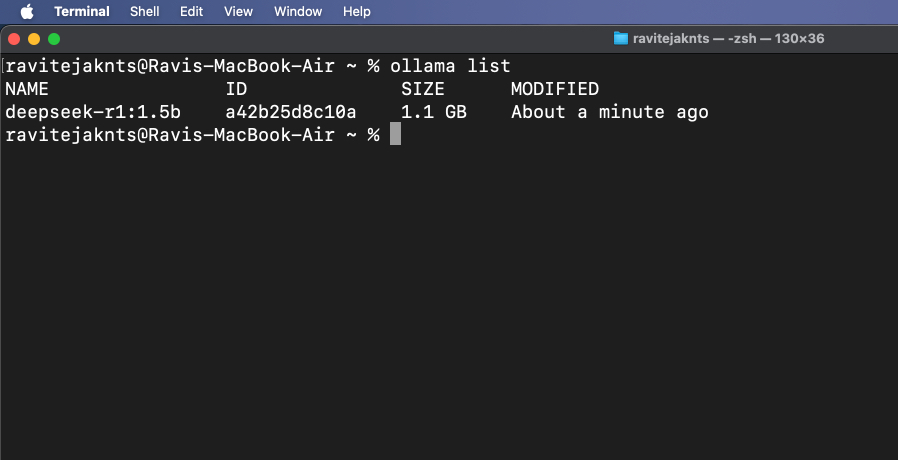

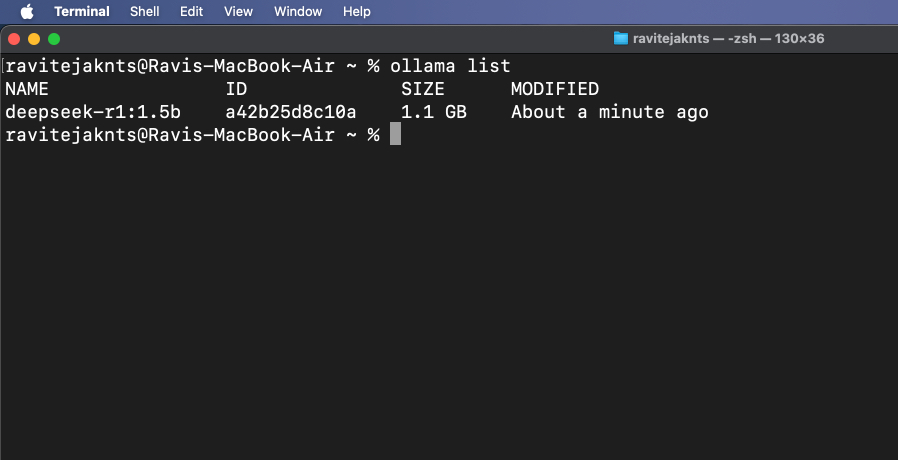

Steg 5: Visa och hantera installerade modeller

För att kontrollera vilka modeller som för närvarande laddas ner, kör:

ollama list

För att ta bort en modell du inte behöver längre, använd:

ollama rm [model-name]Bonus: Använd Ollama med ett användargränssnitt på webben

Medan Ollama körs i terminalen startar den också en lokal API -tjänst på http: // localhost: 11434, så att du kan ansluta den till ett webbgränssnitt för visuell interaktion med modellerna – liknar att använda en chatbot. Ett populärt alternativ för detta är Open WebUI, som ger ett användarvänligt gränssnitt ovanpå Ollamas kärnfunktionalitet. Låt oss se hur du ställer in det.

Steg 1: Installera Docker

Docker är ett verktyg som låter dig paketera ett program och alla dess väsentliga element i en bärbar behållare så att du enkelt kan köra den på alla enheter. Vi använder det för att öppna ett webbaserat chattgränssnitt för din AI-modell.

Om din Mac inte har det redan, följ dessa steg för att installera Docker:

- Ladda ner Dockningsbord För din Mac, kör den och följ instruktionerna på skärmen för att slutföra installationen.

- Starta Docker -appen och logga in.

- Öppna terminal och skriv kommandot nedan för att bekräfta installationen:

docker --version

Om kommandot returnerar ett versionnummer betyder det att Docker är installerat på din Mac.

Steg 2: Dra den öppna Webui -bilden

Open Webui är ett enkelt verktyg som ger dig ett chattfönster i din webbläsare. Att dra bilden bara betyder att ladda ner de filer som behövs för att köra den.

För att göra detta, gå till Terminal -appen och skriv:

docker pull ghcr.io/open-webui/open-webui:mainDetta laddar ner nödvändiga filer för gränssnittet.

Steg 3: Kör Docker -behållaren och öppna Webui

Nu är det dags att köra Open Webui med Docker. Du ser ett rent gränssnitt där du kan chatta med din AI – ingen terminal behövs. Här är vad du behöver göra:

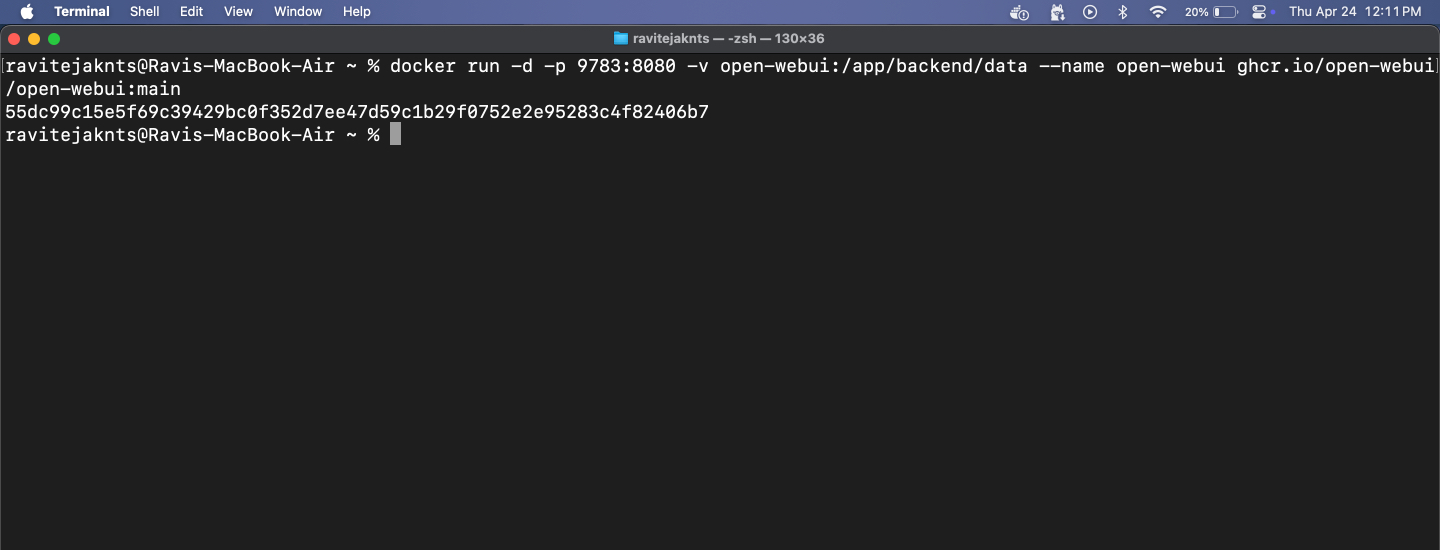

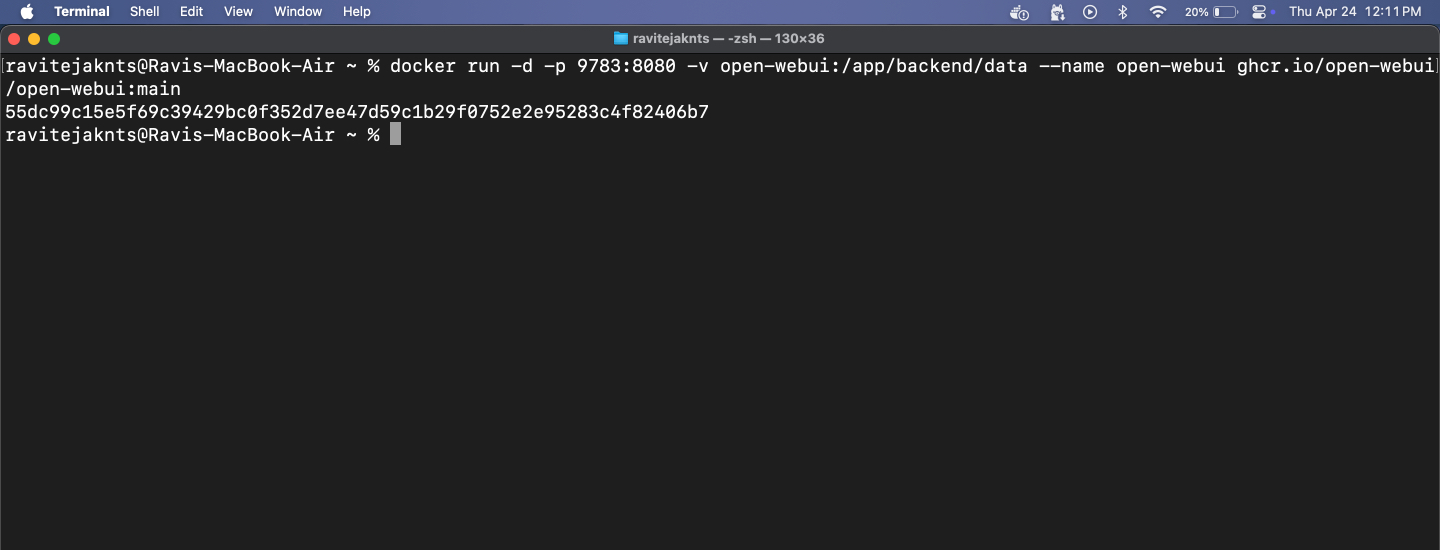

- Starta Docker -behållaren med ihållande datalagring och mappade portar:

docker run -d -p 9783:8080 -v open-webui:/app/backend/data --name open-webui ghcr.io/open-webui/open-webui:main

- Vänta några sekunder på att behållaren ska starta.

- Öppna din webbläsare och gå till:

http://localhost:9783/- Skapa ett konto när du uppmanas, så omdirigeras du till huvudgränssnittet.

Härifrån kan du chatta med vilken installerad modell som helst i ett rent, användarvänligt webbläsargränssnitt. Detta steg är valfritt, men det ger dig en jämnare chattupplevelse utan att använda terminalen.

Din Mac, din AI: Inga servrar, inga strängar

Så är det! På bara några steg har du ställt in din Mac för att köra en kraftfull AI -modell helt offline. Inga konton, inget moln och inget internet behövs efter installationen. Oavsett om du vill ha privata konversationer, lokal textgenerering eller bara vill experimentera med LLMS gör Ollama det enkelt och tillgängligt – även om du inte är en utvecklare. Prova!

Kolla in dessa användbara guider också:

- Hur man kör Android -appar på Mac

- Hur man skärmregister på din Mac

- Hur man installerar git på din Mac